¿Imaginas dedicar tus tardes a innovar en clase en vez de remar entre exámenes? Hoy te cuento, sin filtros, cómo estoy usando modelos de lenguaje gigantes ―los famosos LLM― para corregir con IA manteniendo la rigurosidad pedagógica y, de paso, ganando tiempo para lo que de verdad importa: acompañar a cada estudiante.

De la urgencia a la oportunidad: por qué automatizar la corrección ya no es opcional

El cuello de botella evaluativo

La sobrecarga docente es un mantra conocido: grupos masivos, tareas abiertas y fechas de entrega imposibles. Con las herramientas tradicionales apenas podíamos “irtecleando” rúbricas en hojas de cálculo mientras el reloj destruía nuestra pausa para el café. No es sostenible. Lo que sí es sostenible es delegar el primer pase de corrección en IA: estudios recientes demuestran que los LLM, bien pilotados, igualan el criterio humano en preguntas objetivas y ofrecen feedback formativo casi en tiempo real.

💬 «Automatizar no es ahorrar esfuerzo, es reinvertirlo donde el estudiante lo siente».

Ventanas que se abren: feedback inmediato y datos accionables

Cuando la retroalimentación llega minutos después de entregar, el aprendizaje se vuelve diálogo y no sentencia. Los LLM permiten desglosar cada criterio de la rúbrica, puntuarlo y, sobre todo, explicar la nota en lenguaje cercano. Además, los dashboards generados en segundo plano iluminan patrones de error que a simple vista pasarían desapercibidos. Así, evaluar con IA deja de ser un fin y se convierte en brújula pedagógica.

🗺️ Mapa comparativo: ¿qué existe hoy y dónde pincha?

| Herramienta | Foco principal | Tipo de ítem fuerte | IA integrada | Limitación clave |

|---|---|---|---|---|

| Google Forms / Quizizz | Agilidad en test | Opción múltiple | Baja | Feedback superficial |

| Gradescope | Escalar corrección | Papel, código | IA para agrupar respuestas | Coste + curva de uso |

| Turnitin | Integridad académica | Ensayo digital | IA detección similitud | No corrige MCQ |

| Correctores nativos IA (EssayGrader…) | Ensayo / manuscrito | Texto libre | IA semántica | Evidencia independiente limitada |

| LLM + prompts | Corrección generalista | MCQ, ensayo, código | IA generativa | Variabilidad y sesgo si no hay supervisión |

Observa cómo ningún actor lo hace “todo‑bien” todavía: la clave está en mezclar lo mejor de cada aproximación.

¿Qué aporta un LLM que no aportan las soluciones clásicas?

Comprensión semántica y feedback conversacional

Los LLM leen contexto, razonan, comparan con la rúbrica y generan comentarios en tono humano. Esto significa que pueden valorar creatividad, argumentación o estilo ―territorio hasta ahora vedado a la automatización― y ofrecer ejemplos de mejora específicos.

💡«Un buen feedback no dice qué falló, sino cómo mejorar mañana».

Adaptación instantánea a distintas materias y niveles

Con few‑shot learning basta incluir un par de ejemplos para que el modelo interiorice tu estilo de corrección. Así puedo pasar de Historia de 4.º ESO a un ensayo filosófico de Bachillerato en el mismo flujo, algo impracticable con rúbricas rígidas programadas a mano.

Transparencia con Chain‑of‑Thought

Solicitar al modelo que exponga su razonamiento paso a paso no solo eleva la precisión, sino que aporta auditabilidad: puedo revisar por qué otorgó o restó puntos y rectificar si es necesario.

Limitaciones que no debemos ignorar

🔍 Alucinaciones factuales: el modelo “imagina” datos que no existen.

⚖️ Sesgos: puntuaciones sensibles a longitud de respuesta o vocabulario culto.

🔄 Inconsistencia: misma respuesta, distinta nota si el prompt es ambiguo.

Mitigarlo exige prompts robustos y revisión humana, como veremos enseguida.

Taller práctico: construyendo tu asistente de corrección paso a paso

🛠️ «La primera vez que lancé el asistente me sentí copiloto de un transatlántico: mucho poder y la obligación de trazar bien la ruta para no estrellar la nave».

1️⃣ Recoge los detalles clave

Antes de lanzar el modelo pregunta por asignatura, nivel, edad y tipo de actividad. Sin estos cuatro ejes tu corrección se convierte en dardo a ciegas.

2️⃣ Destila objetivos y confirma con el docente

Lista competencias y destrezas a medir. El usuario (tú) valida o ajusta. Este checkpoint evita malentendidos y alinea la IA con el currículo.

3️⃣ Sincroniza con los criterios oficiales

Pide el documento curricular (LOMLOE o autonómico) y enlázalo para descarga. Solo tras revisar las competencias específicas (CE) y criterios de evaluación (1.1, 1.2…) generas la matriz de rúbrica.

4️⃣ Elige el formato óptimo de evaluación

Ofrece al usuario 2‑3 formatos (test, proyecto, ensayo…) justificando pros y contras. La decisión final debe ser consciente; la IA no debe forzar el camino.

5️⃣ Construye la tabla de evaluación

Organiza cada CE y cada criterio en filas, añade ítems observables y pondera con sensatez. Ejemplo de ítem:

CE2 – Comprender procesos históricos

Criterio 2.1: Analiza causas.

Ítem 2.1a: “Identifica al menos dos causas primarias”.

Ítem 2.1b: “Relaciona causas y consecuencias en >80 palabras”.

6️⃣ Llega la hora de corregir

El usuario sube el trabajo del alumno; el modelo aplica la tabla y emite puntuaciones parciales, nota global y comentario justificado.

7️⃣ Retroalimenta con empatía

Siempre en tono cercano, recalca fortalezas, señala áreas de mejora con ejemplos concretos, e invita a la acción (“Reescribe el párrafo 3 añadiendo…”) para activar el aprendizaje autorregulado.

🧩 Buenas prácticas y ética: mantén al humano en el bucle

Transparencia y rendición de cuentas: el antídoto contra la caja negra

Uno de los principales temores cuando hablamos de evaluar con IA es la opacidad. ¿Por qué este estudiante ha sacado un 6,2 y no un 7,5? ¿Qué criterio se aplicó? ¿Qué pesó más en la evaluación? Sin explicaciones claras, el proceso pierde legitimidad. Por eso, uno de los principios innegociables cuando usamos LLMs es hacer visible el pensamiento del modelo.

🪄 Técnica clave: el Chain-of-Thought fuerza al modelo a razonar paso a paso, aplicando cada criterio de la rúbrica y justificando la nota final.

🧩 Esto no solo mejora la precisión, sino que genera trazabilidad pedagógica: el docente puede auditar, intervenir, ajustar.

🎯 Microcopy: «Si no puedes explicar una nota a tu alumnado, no deberías automatizarla».

Además, incluir en los informes de evaluación una sección tipo “Cómo se ha evaluado”, explicando que se ha usado un LLM con revisión humana, aumenta la confianza y educa sobre el uso responsable de la IA.

Equidad: que la IA no agrande lo que el sistema ya silencia

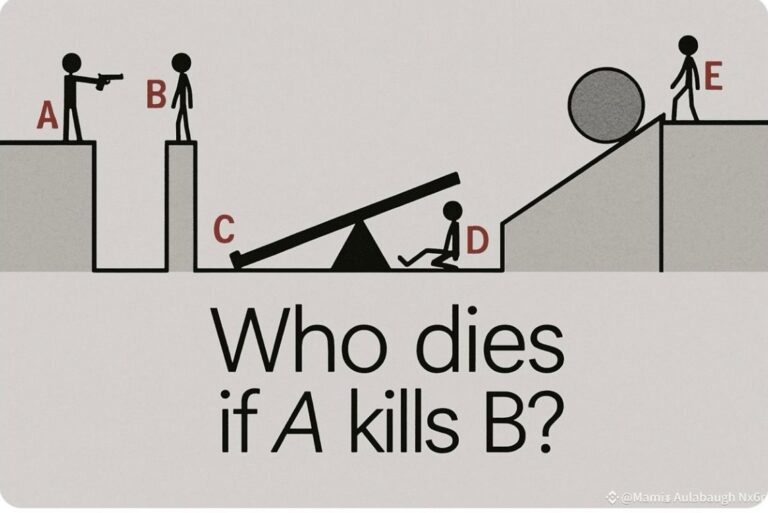

Los LLMs son entrenados con textos que reflejan nuestra cultura, nuestros sesgos… y nuestras desigualdades. Sin intervención crítica, pueden replicar patrones discriminatorios: puntuar peor a quien escribe con faltas ortográficas aunque su razonamiento sea sólido; valorar más el vocabulario culto que la claridad; penalizar estructuras discursivas alejadas del “modelo estándar”.

🧪 Estudios muestran que ChatGPT, sin una rúbrica clara, prefiere respuestas largas y puntuaciones “templadas”, evitando extremos.

🧑🏽🎓 ¿Implicación? Estudiantes con inseguridad o estilos breves y directos pueden salir perjudicados.

La evaluación automatizada tiene que ser intencionalmente equitativa, no simplemente “neutral”.

Buenas prácticas clave:

Incluir ejemplos de distintos niveles de redacción, tipos de lenguaje y estructuras.

Ajustar los prompts para evitar sesgos: “no penalices errores ortográficos menores si no afectan al contenido”, “valora la argumentación aunque no use conectores formales”.

Auditar resultados con datos anonimizados para detectar patrones preocupantes por género, origen o nivel socioeconómico.

🧠 «Una IA justa no se improvisa. Se diseña desde el compromiso y se valida con datos».

Privacidad, consentimiento y control de datos

No podemos hablar de ética sin hablar de datos. Evaluar con LLMs implica procesar textos generados por estudiantes. Esto es información sensible, personal y en muchos casos, confidencial. El RGPD europeo establece límites claros: debe haber consentimiento informado, control del uso de datos y garantías de seguridad.

Checklist mínimo antes de usar un LLM en el aula:

📜 ¿Tu centro tiene una política de privacidad adaptada al uso de IA?

🔐 ¿El modelo está alojado en servidores seguros o locales?

🧾 ¿Las respuestas de estudiantes se anonimizaron antes de subirlas?

En contextos formales, la mejor práctica es usar modelos autoalojados o APIs que permitan desactivar el almacenamiento y reentrenamiento con los datos enviados.

El rol del docente no desaparece. Se transforma

Uno de los mayores riesgos no es técnico, sino cultural: creer que la IA puede sustituir nuestro juicio profesional. La automatización debe liberar tiempo, no quitar voz.

🧭 «El criterio docente es el faro. La IA es solo la linterna que alumbra rincones nuevos».

Por eso, defiendo una visión Human-in-the-Loop reforzada:

Validamos resultados antes de publicarlos.

Revisamos los casos límite o inconsistentes.

Ajustamos prompts y rúbricas en función del contexto.

Y sobre todo, seguimos decidiendo con criterio educativo qué, cómo y por qué se evalúa.

🚀 Oportunidades que ya palpamos… y un par de nubes en el horizonte

El feedback automático como catalizador del aprendizaje autónomo

Hasta ahora, obtener buena retroalimentación era un privilegio de quien tenía acceso a profesorado disponible. Con LLMs bien diseñados, esto puede cambiar radicalmente.

🎯 Imagina esto:

Cada estudiante recibe feedback personalizado, estructurado y formativo minutos después de entregar.

El feedback incluye ejemplos, preguntas reflexivas y sugerencias concretas de mejora.

Puede reentregar tras revisar y mejorar, entrando en un bucle virtuoso de aprendizaje guiado por IA.

Esto ya es posible con plataformas tipo EdPrompt, Khanmigo o Loop que integran IA generativa en entornos LMS.

📣 «El feedback ya no es un privilegio. Es un derecho escalable».

Datos para mejorar la enseñanza, no solo para clasificar

Uno de los grandes tesoros que desbloquea la evaluación con IA es la posibilidad de analizar tendencias de error, conceptos mal entendidos o competencias no adquiridas, en tiempo real y a nivel de clase o individual.

🧭 Con esto, el docente puede:

Detectar qué criterios fallan más y reenseñar de forma dirigida.

Reajustar los tiempos de enseñanza de forma proactiva.

Diseñar actividades correctivas personalizadas.

Y todo esto sin esperar a final de trimestre. El impacto en la evaluación formativa continua es gigantesco.

Amenazas a vigilar: dependencia, sobreconfianza y pedagogía débil

No todo es luz. Hay sombras que conviene señalar.

Dependencia técnica: si el profesorado no se forma, la IA se vuelve una caja negra peligrosa. Necesitamos empoderar al docente como diseñador de prompts y analista del output.

Riesgo de deshumanización: si evaluamos solo lo que la IA puede medir, estamos empobreciendo la educación.

Fatiga de feedback: si los estudiantes reciben comentarios constantes sin orientación ni filtro, pueden saturarse y desconectarse.

⚠️ «Una buena herramienta mal integrada puede hacer más daño que una mala herramienta no usada».

🎯 Conclusión: mi manifiesto personal para corregir con IA

Corregir exámenes se ha convertido, para muchos de nosotros, en un maratón solitario. Los LLM no son la varita mágica, pero sí el exoesqueleto pedagógico que nos permite llegar más lejos sin rompernos. Cuando diseño un prompt, siento que programo mi criterio en una máquina que me devuelve horas y, lo más importante, un feedback que los estudiantes leen y accionan.

🔥 «¿Te animas a probar tu propio asistente? Empieza pequeño: un cuestionario, una rúbrica, un prompt bien pensado. Y cuéntame en comentarios cómo ha cambiado tu aula».