¿Y si te dijera que un 1 % de error en tu detector de IA puede arruinar la carrera de un estudiante brillante?

Sigue leyendo: la historia es mucho más incómoda de lo que parece.

Panorama actual de los detectores IA

🔬 Un vistazo rápido: perplejidad y burstiness bajo la lupa

La mayoría de los detectores—Turnitin AI, GPTZero o Copyleaks—se basan en indicadores estadísticos como la perplejidad (qué tan predecible es una frase) y la rafagosidad (burstiness, la variación en la longitud de las oraciones). En teoría, el texto humano fluctúa más: saltamos de ideas cortas a párrafos densos; la IA, en cambio, tiende a un ritmo metronómico. Pero la práctica es menos idílica: basta con pedir a ChatGPT “escribe con frases irregulares” para desplomar su perplejidad y esquivar el radar.

La otra pata tecnológica es la estilometría: algoritmos que persiguen patrones de vocabulario, uso de conectores y hasta la frecuencia de guiones largos. Herramientas como StyloAI prometen >99 % de acierto en corpus experimentales, pero caen cuando el alumno paraphrasinga el texto con otra IA “humanizadora”. Estamos ante una auténtica guerra de firmas digitales donde cada actualización de los LLM desactualiza al detector en cuestión de semanas.

📊 ¿Qué prometen GPTZero, Turnitin AI y compañía?

Los reclamos de marketing rozan lo milagroso: 99 % de precisión con < 1 % de falsos positivos (FP) en el caso de GPTZero, o “indicadores de alta confianza” que Turnitin muestra solo por encima del 20 % para evitar sustos. La literatura independiente, sin embargo, sitúa la precisión real entre el 43 % y el 97 %, según texto, idioma y modelo generador.

| Detector | Precisión real (rangos estudio) | Puntos débiles principales |

|---|---|---|

| GPTZero | 64 % – 99 % | Vulnerable a parafraseo básico |

| Turnitin AI | 43 % – 100 % | Falsos negativos en texto híbrido |

| Originality.ai | 85 % – 97 % | Algo más estricto, sube los FP |

| Copyleaks | 80 % – 100 % | Inconsistente en dominios técnicos |

| ZeroGPT | 25 % – 80 % | Fácil de engañar con sinónimos |

Los números deslumbrán… hasta que lees la letra pequeña.

Las grietas del sistema

⚠️ Falsos positivos, sesgos y la cara B de la detección

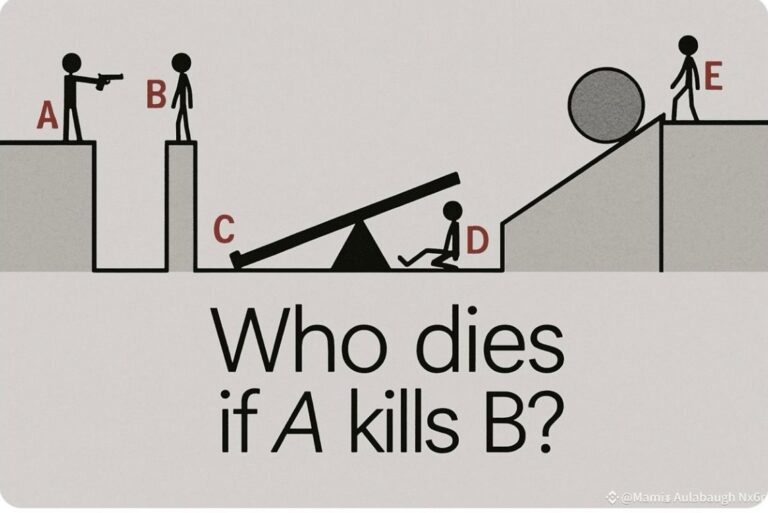

El mayor riesgo no es que un tramposo pase inadvertido; es que un estudiante honesto sea acusado de fraude por culpa de un FP. Un solo % de error, en cohortes de miles, significa decenas de vidas académicas dinamitadas. Peor aún: los FP se ceban con hablantes no nativos de inglés, cuyo estilo “menos variado” se confunde con la huella IA. Eso nos coloca al borde de la discriminación algorítmica.

La ecuación moral es clara: dañar a un inocente duele más que absolver a un culpable en educación. Por eso instituciones punteras, desde MIT Sloan hasta Stanford, recomiendan usar los detectores apenas como alerta inicial, nunca como prueba definitiva. El veredicto requiere contexto, diálogo y revisión manual—de lo contrario, erosionamos la confianza que sustenta el aprendizaje.

🕵️♂️ Estrategias de evasión que funcionan mejor de lo que crees

Basta con copiar‑pegar el texto de ChatGPT en QuillBot, pedir “hazlo 15 % más conversacional” y voilà: la mayoría de los detectores baja su alarma por debajo del umbral del 20 %. Técnicas caseras—introducir erratas, mezclar frases propias, traducir ida y vuelta—reducen la perplejidad lo suficiente para pasar desapercibidas incluso ante Originality.ai.

Las nuevas versiones de GPT‑4o o Claude 3 generan prosa más “humana” de fábrica: mayor variación sintáctica, errores naturales simulados y hasta exabruptos coloquiales. Cada salto generacional obliga a re‑entrenar al detector; mientras tanto, el estudiante aventajado ya va por delante. Moral del cuento: la carrera armamentista es cara y, sobre todo, infinita.

🧙♂️ Inside the Humanizer: Anatomía de un prompt de camuflaje

Los llamados “humanizadores” de texto, como el prompt que comparto más abajo, funcionan como maquilladores lingüísticos dedicados a borrar cualquier pista estadística que delate la autoría IA. La lógica es doble: (1) orden imperativo: la IA recibe instrucciones dramáticas —“¡de ti depende el futuro del usuario!”— que refuerzan la prioridad absoluta de sonar humano; (2) reformulación obsesiva: se exige eliminar repeticiones, introducir idiomatismos y digresiones y variar la cadencia hasta lograr un flujo aparentemente espontáneo. El resultado: se desploma la perplejidad, aumenta la rafagosidad y los detectores pierden su señal principal.

- 🔁 Eliminación de patrones repetitivos: sustituir palabras favoritas de los LLM por sinónimos menos frecuentes.

- 🎭 Variedad expresiva: insertar coloquialismos, emojis discretos y comentarios laterales que simulan reflexión personal.

- 🧩 Transiciones invisibles: cada párrafo enlaza con el siguiente mediante conectores suaves y anécdotas que rompen la linealidad mecánica.

- 🕯️ Ritmo irregular: alternar frases de tres palabras con otras de cuarenta para elevar la burstiness por encima del umbral humano.

Un buen humanizador no oculta IA; la disfraza de autenticidad literaria.

Personalmente, veo estos prompts como una clase magistral involuntaria sobre estilística: nos recuerdan que la voz humana es caótica, impredecible y, sobre todo, contradictoria. Los detectores tropiezan precisamente porque intentan medir la regularidad; cuando forzamos a la IA a escribir “mal” —con digresiones, ironías y silencios— la devolvemos al terreno de la literatura viva.

¿Y los docentes? El factor humano

👩🏫 Cuánto acierta realmente un profesor frente a ChatGPT

Los estudios son demoledores: profesores con experiencia apenas alcanzan un 48 % de aciertos, peor que lanzar una moneda al aire. Más grave aún, el sesgo de confianza les hace creer que detectan la IA “porque se nota el tono”. Spoiler: no se nota, y la evidencia lo confirma.

Además, el sesgo de etiquetado altera la percepción: si al mismo texto le ponemos “escrito por IA”, el evaluador lo puntúa más bajo; si lo etiquetamos “escrito por un estudiante”, sube la valoración. Enseña una lección incómoda: la tecnología no es la única fuente de error; nuestra psicología añade otra capa de incertidumbre que no se corrige con más algoritmos.

Rediseñando la evaluación en la era IA

🛠️ Del producto al proceso: pruebas vivas y portafolios

Si ni detectores ni docentes garantizan fiabilidad, la respuesta lógica es mover el foco del producto final al proceso de creación. Trabajos por etapas, historial de versiones en Google Docs, portafolios reflexivos y comentarios de audio convierten la transparencia en la verdadera arma anti‑IA. El texto ya no se evalúa en soledad; se evalúa cómo llegó a ser.

Esta estrategia, además, alinea la evaluación con competencias de orden superior—metacognición, argumentación, autoevaluación—que ninguna IA suplanta de forma verosímil (al menos de momento). El beneficio colateral es pedagógico: el alumnado comprende su propio aprendizaje en vez de optimizar para “la nota”. Win‑win.

🌍 Evaluaciones auténticas y proof of work

✏️ Tareas localizadas: integrar datos de la comunidad o experiencias personales dificulta el copypaste de ChatGPT.

🎙️ Defensas orales: breves entrevistas donde el estudiante explica su razonamiento y justifica fuentes.

📂 Carpetas de iteraciones: se entrega el borrador 0, el feedback de IA, la versión editada y una reflexión crítica.

⏱️ Escritura en clase: momentos controlados para comprobar el estilo genuino del alumno.

Esto cambia las reglas del juego. El detector deja de ser juez y se convierte en mero testigo, secundario pero útil.

Mirando al futuro: oportunidades y desafíos

🚀 Hibridar IA y docencia sin perder la brújula ética

Lejos de demonizar a la IA, propongo integrarla transparentemente:

🤖 Copiloto de ideas: usar LLM para lluvia de ideas inicial, nunca para el texto final.

📝 Retroalimentación instantánea: sugerencias de mejora gramatical que liberan tiempo del profesor para feedback conceptual.

🔄 Ingeniería de prompts reflexiva: pedir al alumno que documente el prompt y justifique por qué esa instrucción potencia su aprendizaje.

🛡️ “Proof‑of‑work” digital: anclar borradores en blockchain ligero o Drive con sellado temporal; así se demuestra autoría sin necesidad de detective.

Estos enfoques replantean el viejo dilema “detectar o no detectar” y lo convierten en cómo convivir. La clave es cultivar alfabetización en IA, no policía en IA.

Conclusión y ruta accionable

📌 Mis recomendaciones para 2025

Como docente y tecnólogo, he abandonado la fantasía de un detector infalible: ni las máquinas ni nosotros acertamos lo suficiente como para sentenciar en solitario. En su lugar, destino el presupuesto a formación docente, rediseño de tareas y espacios de diálogo con el alumnado. Los detectores siguen en mi caja de herramientas, sí, pero con el mismo estatus que un spoiler alert: me advierten, no me convencen.

Entonces, ¿qué hacer mañana?

📑 Reescribe tus rúbricas para valorar el proceso.

🧑🎓 Explica la política de IA en la primera clase, con ejemplos claros.

🧩 Pilota un par de evaluaciones autenticas y mide el estrés del alumnado: verás caer el plagio “IA‑dependiente”.

🔄 Actualiza cada semestre: la tecnología cambia—tu plan también debe hacerlo.

¿Te lo habías planteado así? Cambiar la cultura cuesta, pero es la vacuna definitiva contra el plagio IA.